- Укрощение Гигантов: Как мы победили большие объемы графических данных

- Первые шаги: осознание масштаба проблемы

- Выбор инструментов и технологий

- Оптимизация хранения данных

- Пример: Сжатие изображений

- Оптимизация обработки данных

- Пример: Параллельная обработка изображений

- Мониторинг и анализ производительности

- Рекомендации

Укрощение Гигантов: Как мы победили большие объемы графических данных

Привет‚ друзья! Сегодня мы хотим поделиться с вами нашим опытом работы с большими объемами графических данных. Это тема‚ которая волнует многих‚ кто занимается обработкой изображений‚ видео‚ 3D-моделей и других визуальных материалов. Мы расскажем‚ с какими трудностями столкнулись‚ какие инструменты использовали и какие стратегии оказались наиболее эффективными. Надеемся‚ наш опыт будет полезен и вдохновит вас на новые свершения!

Первые шаги: осознание масштаба проблемы

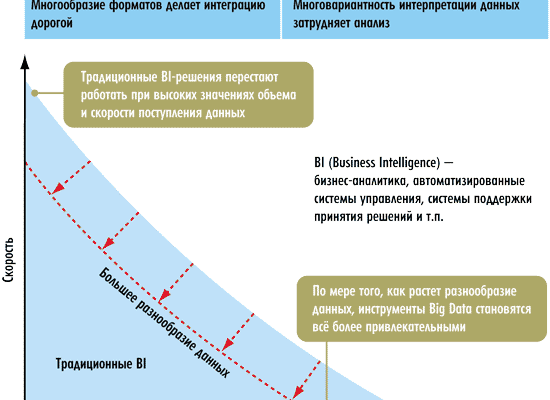

В начале нашего пути мы наивно полагали‚ что сможем справиться с большими объемами графики «на коленке». Но очень быстро поняли‚ что это не так. Представьте себе: терабайты данных‚ миллионы файлов‚ сложная структура каталогов. Обработка‚ анализ‚ визуализация – все это требовало огромных вычислительных ресурсов и времени. Мы столкнулись с медленной загрузкой‚ зависаниями программ‚ нехваткой памяти и другими неприятностями. Тогда мы поняли‚ что нужно серьезно подойти к вопросу оптимизации.

Выбор инструментов и технологий

Первым делом мы занялись выбором инструментов и технологий. Нам нужны были решения‚ которые позволяли бы эффективно работать с большими объемами данных‚ обеспечивали высокую производительность и масштабируемость. Мы рассмотрели различные варианты‚ включая специализированные библиотеки‚ облачные сервисы и аппаратные ускорители. В конечном итоге‚ мы остановились на комбинации нескольких инструментов‚ которые лучше всего соответствовали нашим потребностям:

- Библиотеки для обработки изображений: OpenCV‚ Pillow‚ scikit-image.

- Инструменты для анализа данных: NumPy‚ Pandas‚ SciPy.

- Облачные сервисы: AWS S3‚ Google Cloud Storage‚ Azure Blob Storage.

- Языки программирования: Python‚ C++.

Оптимизация хранения данных

Следующим важным шагом была оптимизация хранения данных. Мы поняли‚ что правильная организация файлов и эффективное использование дискового пространства могут существенно повысить производительность. Вот несколько стратегий‚ которые мы использовали:

- Сжатие данных: Мы использовали различные алгоритмы сжатия‚ такие как JPEG‚ PNG‚ ZIP‚ чтобы уменьшить размер файлов и сэкономить место на диске.

- Разделение данных на части: Мы разбивали большие файлы на более мелкие‚ чтобы упростить обработку и загрузку.

- Использование облачных хранилищ: Мы перенесли часть данных в облачные хранилища‚ чтобы получить доступ к ним из любой точки мира и воспользоваться преимуществами масштабируемости облачных сервисов.

Пример: Сжатие изображений

Давайте рассмотрим пример сжатия изображений. Мы использовали библиотеку Pillow для сжатия JPEG-файлов. Это позволило нам уменьшить размер файлов в несколько раз без существенной потери качества. Вот пример кода:

from PIL import Image

import os

def compress_jpeg(input_path‚ output_path‚ quality=85):

try:

image = Image.open(input_path)

image.save(output_path‚ "JPEG"‚ optimize=True‚ quality=quality)

print(f"Сжатие файла {input_path} успешно завершено.")

except Exception as e:

print(f"Ошибка при сжатии файла {input_path}: {e}")

# Пример использования

input_file = "image.jpg"

output_file = "image_compressed.jpg"

compress_jpeg(input_file‚ output_file)

Оптимизация обработки данных

После оптимизации хранения данных мы перешли к оптимизации обработки данных. Здесь нам пришлось приложить немало усилий‚ чтобы ускорить выполнение различных операций‚ таких как чтение‚ запись‚ преобразование и анализ. Вот несколько методов‚ которые мы использовали:

- Параллельная обработка: Мы использовали многопоточность и многопроцессорность для параллельной обработки данных. Это позволило нам значительно ускорить выполнение задач‚ особенно тех‚ которые можно разделить на независимые части.

- Векторизация: Мы использовали векторизованные операции NumPy для ускорения математических вычислений. Векторизация позволяет выполнять операции над массивами данных без использования циклов‚ что значительно повышает производительность.

- Использование GPU: Мы использовали графические процессоры (GPU) для ускорения выполнения сложных вычислений‚ таких как сверточные нейронные сети. GPU обладают высокой вычислительной мощностью и позволяют выполнять параллельные вычисления гораздо быстрее‚ чем CPU.

«Данные ― это новая нефть. Но‚ как и нефть‚ они бесполезны‚ если не переработаны.» ― Клайв Хамби

Пример: Параллельная обработка изображений

Давайте рассмотрим пример параллельной обработки изображений. Мы использовали библиотеку `concurrent.futures` для параллельного применения фильтра к нескольким изображениям. Это позволило нам значительно ускорить обработку большого количества файлов.

import os

from PIL import Image‚ ImageFilter

import concurrent.futures

def apply_filter(input_path‚ output_path‚ filter):

try:

image = Image.open(input_path)

filtered_image = image.filter(filter)

filtered_image.save(output_path)

print(f"Фильтр применен к файлу {input_path}")

except Exception as e:

print(f"Ошибка при обработке файла {input_path}: {e}")

def process_images(image_paths‚ output_dir‚ filter):

with concurrent.futures.ThreadPoolExecutor as executor:

for input_path in image_paths:

output_path = os.path.join(output_dir‚ os.path.basename(input_path))

executor.submit(apply_filter‚ input_path‚ output_path‚ filter)

# Пример использования

image_dir = "images"

output_dir = "images_filtered"

image_paths = [os.path.join(image_dir‚ f) for f in os.listdir(image_dir) if f.endswith(".jpg")]

os.makedirs(output_dir‚ exist_ok=True)

process_images(image_paths‚ output_dir‚ ImageFilter.BLUR)

Мониторинг и анализ производительности

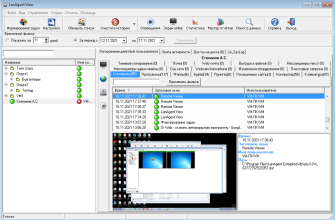

Наконец‚ мы внедрили систему мониторинга и анализа производительности‚ чтобы отслеживать время выполнения различных операций‚ загрузку CPU‚ использование памяти и другие важные показатели. Это позволило нам выявлять узкие места и оперативно реагировать на проблемы. Мы использовали такие инструменты‚ как:

- Профилировщики: cProfile‚ line_profiler.

- Инструменты мониторинга: Grafana‚ Prometheus.

Благодаря мониторингу мы смогли постоянно улучшать наши стратегии оптимизации и добиваться все большей производительности.

Работа с большими объемами графических данных – это сложная‚ но интересная задача. Она требует не только глубоких знаний в области обработки изображений и анализа данных‚ но и умения эффективно использовать инструменты и технологии‚ а также постоянно оптимизировать процессы. Мы надеемся‚ что наш опыт будет полезен вам в вашей работе. Удачи!

Рекомендации

- Планируйте заранее: Тщательно спланируйте архитектуру вашей системы‚ прежде чем приступить к разработке.

- Используйте правильные инструменты: Выберите инструменты и технологии‚ которые лучше всего соответствуют вашим потребностям.

- Оптимизируйте хранение данных: Правильно организуйте файлы и используйте эффективные методы сжатия.

- Оптимизируйте обработку данных: Используйте параллельную обработку‚ векторизацию и GPU для ускорения вычислений.

- Мониторьте производительность: Внедрите систему мониторинга и анализа производительности‚ чтобы выявлять узкие места и оперативно реагировать на проблемы.

Подробнее

| Обработка больших изображений | Оптимизация графических данных | Ускорение обработки видео | Анализ больших массивов изображений | Эффективное хранение графики |

|---|---|---|---|---|

| Работа с 3D моделями больших размеров | Параллельная обработка графики | Использование GPU для графики | Сжатие графических данных | Cloud Storage для графики |